Einblick in die Firmengeschichte von OpenAI

Symbolträchtig: das Logo von OpenAI, eine Kreuzung aus Mandala und Rosenblüte, die unendlich in sich selbst gefaltet ist.

(Bild: Christie Hemm Klok)

OpenAI wurde gegründet, um künstliche Intelligenz zum Nutzen der gesamten Menschheit zu erforschen. Wettbewerbsdruck hat diesen Idealismus untergraben.

Jedes Jahr stimmen die Mitarbeiter von OpenAI darüber ab, wann intelligente Maschinen ihrer Meinung nach wirklich intelligent werden – also nicht wie bisher Fachidioten mit Inselbegabung bleiben, sondern eine Intelligenz zeigen, die mit der menschlichen vergleichbar ist. Im Englischen hat sich dafür die Abkürzung AGI eingebürgert, Artificial General Intelligence. Die meisten sehen in der Umfrage eine Art Spiel, und die Einschätzungen gehen weit auseinander. Doch obwohl in der Wissenschaft immer noch diskutiert wird, ob menschenähnliche autonome Systeme überhaupt möglich sind, wettet die Hälfte der Labors, dass es wahrscheinlich innerhalb von 15 Jahren geschehen wird.

Anlässlich der Spekulationen um OpenAIs möglichen Durchbruch auf dem Gebiet der künstlichen, allgemeinen Intelligenz veröffentlichen wir diesen Artikel frei zugänglich. Der Text erschien ursprünglich in Ausgabe 4/2020 von MIT Technology Review. [1]

Kein Wunder, denn in den sieben Jahren seit seiner Gründung hat sich OpenAI zu einem der weltweit führenden Forschungslabore für Künstliche Intelligenz [2] entwickelt, das neben Schwergewichten wie Alphabets DeepMind immer wieder für Schlagzeilen sorgt.

Aber das Ziel von OpenAI ist nicht nur, die erste AGI zu schaffen. [3] Das Labor will zudem sicherstellen, dass die Vorteile der Technologie der gesamten Menschheit zugute kommen. Denn anders als die schwerreichen Unternehmen der Hightech-Branche ist OpenAI als gemeinnützige Organisation organisiert. Die Charta mit den Zielen des Unternehmens erklärt, dass OpenAI „die primäre treuhänderische Pflicht gegenüber der Menschheit“ hat. Es sei so wichtig, AGI sicher zu entwickeln, dass OpenAI, sollte eine andere Organisation kurz vor diesem Durchbruch stehen, nicht mehr mit ihr konkurrieren, sondern zusammenarbeiten würde.

Aber drei Tage im Jahr 2020 im Büro von OpenAI und fast drei Dutzend Interviews mit ehemaligen und aktuellen Mitarbeitern, Freunden und Experten lassen ein anderes Bild erkennen. Es besteht eine Diskrepanz zwischen dem, was das Unternehmen öffentlich verkündet, und der Art und Weise, wie es hinter verschlossenen Türen arbeitet. Ein harter Konkurrenzkampf und ein wachsender Druck auf der Suche nach immer mehr Finanzmitteln haben die Gründungsideale von Transparenz, Offenheit und Zusammenarbeit untergraben.

Am Anfang hatte OpenAI eine klare Botschaft

OpenAI war nicht das erste Unternehmen, das erklärte, eine AGI entwickeln zu wollen. DeepMind [4] hatte dies fünf Jahre zuvor getan. Aber OpenAI war etwas anderes: Das Unternehmen begann zum einen mit einer Milliarde Dollar Startkapital von namhaften privaten Investoren, darunter Elon Musk, Sam Altman, Gründer der Start-up-Schmiede Y Combinator, sowie PayPal-Mitbegründer Peter Thiel.

Vor allem aber begann es mit einer klaren Botschaft: „Es wird wichtig sein, eine führende Forschungseinrichtung zu haben, die ein gutes Ergebnis für alle über ihre eigenen Interessen stellen kann“, hieß es in der Ankündigung. „Unsere Forscher werden nachdrücklich ermutigt, ihre Arbeit zu veröffentlichen, sei es als Aufsätze in Fachzeitschriften, Blog-Posts oder Code, und unsere Patente (falls es welche gibt) werden mit der ganzen Welt geteilt.“ Obwohl das explizit nie so geäußert wurde, war klar, dass damit eine implizite Kritik an anderen verbunden ist: Labore wie DeepMind könnten der Menschheit nicht dienen, weil sie durch kommerzielle Interessen eingeschränkt wären.

Mit seiner grau-blauen Vertäfelung, den getönten Fenstern und dem roten Schriftzug „Pioneer Building“ – die Überreste seines früheren Besitzers, der Pioneer Truck Factory – erinnert der Firmensitz von OpenAI in San Francisco an ein altmodisches Bürogebäude. Im Inneren ist das Gebäude jedoch hell und luftig. Im ersten Stock gibt es einige Gemeinschaftsräume und zwei Konferenzräume. Ihre Namen zeugen von Nerd-Humor: Der eine heißt „A Space Odyssey“; der andere, nur unwesentlich größer als eine Telefonzelle, heißt „Infinite Jest“. Dies ist der Raum, auf den ich während meines Besuchs beschränkt bin. Es ist mir verboten, den zweiten und dritten Stock zu besuchen, in denen alle Schreibtische, mehrere Roboter und so ziemlich alles Interessante untergebracht ist. Wenn es Zeit für ihre Interviews ist, kommen die Leute zu mir herunter. Ein Angestellter hat zwischen den Treffen ein wachsames Auge auf mich.

(Bild: Christie Hemm Klok)

Trotz dieser Einschränkungen ist Cheftechnologe Greg Brockman nervös und zurückhaltend. „Wir haben noch nie jemandem so viel Zugang gewährt“, sagt er mit einem zaghaften Lächeln. Er trägt legere Kleidung und, wie viele bei OpenAI, einen unförmigen Haarschnitt, der eine effiziente, schnörkellose Mentalität zu reflektieren scheint.

Neues Organisationsmodell musste her

Brockman nimmt mich zum Mittagessen mit. Im Café auf der anderen Straßenseite spricht er intensiv, aufrichtig und staunend über OpenAI und zieht dabei oft Parallelen zwischen seiner Mission und den großen Errungenschaften der Wissenschaftsgeschichte. Sein Lieblingsthema ist das Rennen zum Mond. Die Botschaft ist klar: Die Leute können so skeptisch sein, wie sie wollen. Das ist der Preis, den man für großen Wagemut zahlen muss.

Während des gesamten Mittagessens rezitiert Brockman auch immer wieder die OpenAI-Charta, eine Erklärung für jeden Aspekt der Existenz des Unternehmens. Im März 2017, 15 Monate nach der Gründung, diskutierte Brockman mit einigen Kollegen den Entwurf eines internen Dokuments, das den Weg zu AGI aufzeigen sollte. Als das Team die Trends in diesem Bereich untersuchte, erkannte es, dass es finanziell unhaltbar sein würde, eine gemeinnützige Organisation zu bleiben. Die rechnerischen Ressourcen, die andere im Feld verwendeten, verdoppelten sich alle drei bis vier Monate. Es wurde klar, dass sie, „um relevant zu bleiben“, so Brockman, „genug Kapital benötigen würden, um diesen exponentiellen Anstieg zu erreichen oder zu übertreffen“. Das erforderte ein neues Organisationsmodell, das schnell Geld anhäufen konnte – und gleichzeitig irgendwie auch der Mission treu blieb.

Ohne dass die Öffentlichkeit – und die meisten Mitarbeiter – davon wusste, veröffentlichte OpenAI im April 2018 daher seine Charta. In dem Dokument wurden die Kernwerte des Labors neu formuliert, aber die Sprache wurde subtil geändert, um die neue Realität widerzuspiegeln. So steht die Verpflichtung „zu vermeiden, dass eine Nutzung von KI oder AGI ermöglicht wird, die der Menschheit schadet oder die Macht unangemessen konzentriert“, neben der Erkenntnis, „dass wir erhebliche Ressourcen bereitstellen müssen, um unsere Mission zu erfüllen“. Gleichzeitig versichert OpenAI: „Wir werden immer sorgfältig handeln, um Interessenkonflikte unter unseren Mitarbeitern und Interessengruppen zu minimieren, die den allgemeinen Nutzen gefährden könnten.“

Zu einer Art Testlauf für diese Versicherung sollte der 14. Februar 2019 werden. An diesem Tag kündigte das Labor beeindruckende neue Forschungsergebnisse an: Ein tiefes neuronales Netz konnte auf Knopfdruck überzeugende Essays und Artikel generieren. Füttere man es mit einem Satz aus „Der Herr der Ringe“ oder dem Beginn einer fiktiven Nachricht über Miley Cyrus’ Ladendiebstahl, vervollständigte die Software den Text in der gleichen Art und Weise.

Algorithmen, die zu gefährlich sind

Aber es gab einen Haken: Die Forscher hielten das Modell, GPT-2 genannt [5], für zu gefährlich, um es zu veröffentlichen. Wenn eine solch mächtige Technologie in die falschen Hände geriete, könnte sie leicht zur Waffe umgewandelt werden, um Desinformationen im großen Maßstab zu produzieren.

Die Kritik folgte prompt: Einige Forscher sagten, OpenAI ziehe einen Publicity-Gag ab. GPT-2 sei nicht annähernd fortschrittlich genug, um eine Bedrohung darzustellen. Und wenn dem so wäre, warum sollte man seine Existenz bekannt geben und dann die öffentliche Kontrolle verhindern? „Es schien, als ob OpenAI versucht hat, aus der Panik Kapital zu schlagen“, sagt Britt Paris, Assistenzprofessor an der Rutgers University, der sich mit KI-generierter Desinformation beschäftigt.

Kursänderung deutet sich an

Im März 2019 änderte OpenAI dann seine Struktur. Neben dem gemeinnützigen Verein gab es eine profitorientierte Abteilung, deren Gewinn auf das 100-Fache der Investitionen gedeckelt werden sollte. Kurz darauf investierte Microsoft eine Milliarde Dollar – die Hälfte allerdings in Form von Rechenzeit in Microsofts Cloud-Computing-Plattform Azure.

Im Mai 2019 revidierte OpenAI seine Haltung zu GPT-2 und kündigte eine „gestufte Veröffentlichung“ an [6]. In den folgenden Monaten wurden nach und nach immer leistungsfähigere Versionen von GPT-2 herausgebracht. In der Zwischenzeit arbeiteten die Wissenschaftler mit mehreren Forschungsorganisationen zusammen, um das Missbrauchspotenzial des Algorithmus zu untersuchen und mögliche Gegenmaßnahmen zu entwickeln. Schließlich veröffentlichten sie im November den vollständigen Code, nachdem sie „bisher keine eindeutigen Beweise für einen Missbrauch gefunden hatten“.

Doch die organisatorischen Änderungen in dem Forschungslabor und die Abkehr von der reinen Gemeinnützigkeit beförderten neue Gerüchte. Die Öffentlichkeit spekulierte, ob OpenAI die Technologie möglicherweise in Vorbereitung auf eine zukünftige Lizenzierung unter Verschluss gehalten habe. Die Leute, die diese Frage stellten, konnten nicht wissen, das GPT-2 nicht der einzige Fall war, in dem OpenAI sich entschieden hatte, seine Forschungsergebnisse zu verstecken. Tatsächlich hatte es einen weiteren Versuch völlig geheim gehalten.

Dieser Versuch hängt eng mit der Frage zusammen, wie AGI konkret erreicht werden kann. Es gibt zwei vorherrschende Theorien darüber, was dafür notwendig ist: In der einen Theorie sind alle notwendigen Techniken bereits vorhanden; der Rest ist nur eine Frage der Skalierung und des Zusammenbaus. Andere Forscher hingegen gehen davon aus, dass noch grundsätzliche wissenschaftliche Durchbrüche fehlen.

Die meisten Forscher liegen irgendwo zwischen diesen Extremen, aber OpenAI hat sich stets fast ausschließlich auf den Aspekt der Skalierung und Systemintegration konzentriert. Die meisten ihrer Durchbrüche beruhten auf dramatisch größeren Berechnungsressourcen.

Geheimniskrämerei bei OpenAI

Brockman und der OpenAI-Chefwissenschaftler Ilya Sutskever bestreiten, dass dies ihre einzige Strategie ist, aber die streng bewachte Forschung des Labors legt etwas anderes nahe. Ein Team namens Foresight führt Experimente durch, um zu testen, wie weit sie die KI-Fähigkeiten durch das Training bestehender Algorithmen mit immer größeren Datenmengen und Rechenleistung vorantreiben können. Etwa sechs Monate lang wurden diese Ergebnisse der Öffentlichkeit verborgen, weil OpenAI dieses Wissen als seinen wichtigsten Wettbewerbsvorteil ansah. Mitarbeiter und Praktikanten wurden ausdrücklich angewiesen, sie nicht preiszugeben, und diejenigen, die das Unternehmen verließen, unterzeichneten Geheimhaltungsvereinbarungen. Erst im Januar veröffentlichte das Team ohne den üblichen Trubel in aller Stille eine Studie dazu. Diejenigen, die die intensive Geheimhaltung um die Versuche herum erlebt hatten, wussten nicht, was sie von dieser Änderung halten sollten. Bemerkenswert ist allerdings, dass einen Monat zuvor eine Studie mit ähnlichen Ergebnissen veröffentlicht wurde – und zwar unabhängig von OpenAI.

Während dieser Grad an Geheimhaltung zu Anfang nie beabsichtigt war, ist er inzwischen zur Gewohnheit geworden. Als ich nach meinen ersten Besuchen im Büro begann, mit verschiedenen Mitarbeitern Kontakt aufzunehmen, erhielt ich eine E-Mail von der Leiterin der Kommunikationsabteilung, die mich daran erinnerte, dass alle Interviewanfragen über sie laufen müssten. Als ich dies mit der Begründung ablehnte, das würde die Relevanz dessen, was mir die Leute gesagt hatten, untergraben, wies sie die Mitarbeiter an, sie über meinen Einsatz auf dem Laufenden zu halten. Eine Slack-Nachricht von Clark, einem ehemaligen Journalisten, lobte später die Leute dafür, dass sie sich bedeckt hielten, da ein Reporter „herumschnüffelte“.

Eines der größten Geheimnisse ist das Projekt, an dem OpenAI als Nächstes arbeitet. Quellen beschrieben es mir als den Höhepunkt der vorangegangenen vier Jahre Forschung: ein KI-System, das mit Bildern, Text und anderen Daten unter Einsatz massiver Rechenressourcen trainiert wird.

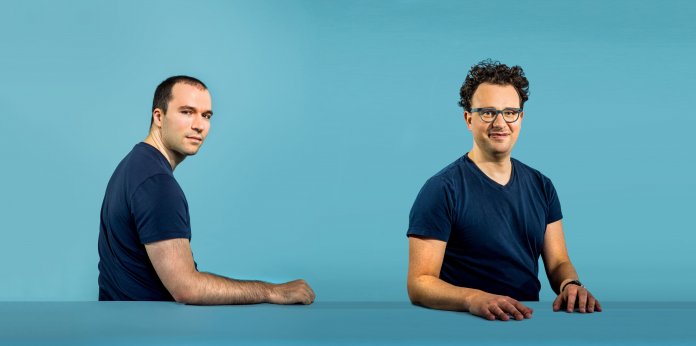

(Bild: Christie Hemm Klok)

Mit welcher Strategie OpenAI derartige Projekte vorantreibt, erklärt mir Dario Amodei, ein Ex-Google-Mann, der jetzt als Forschungsdirektor fungiert. Er kommt mir vor wie eine ängstlichere Version von Brockman – eine ähnliche Aufrichtigkeit und Sensibilität, aber einen Hauch von unruhiger, nervöser Energie. Er sieht beim Sprechen distanziert aus, die Brauen gerunzelt, eine Hand zerrt zerstreut an seinen Locken.

"Portfolio von Wetten"

Amodei teilt die Strategie des Labors in zwei Teile auf. Den ersten Teil, in dem es darum geht, fortgeschrittene KI-Fähigkeiten zu erreichen, vergleicht er mit dem „Portfolio von Wetten“ eines Investors. Das Sprachenteam zum Beispiel setzt darauf, dass KI durch bloßes Erlernen von Sprachen ein bedeutendes Verständnis der Welt entwickeln kann. Das Roboterteam hingegen vertritt die gegensätzliche Theorie, dass Intelligenz eine physische Verkörperung benötigt, um sich zu entwickeln.

Wie im Portfolio eines Investors hat nicht jede Wette das gleiche Gewicht. Aber alle Wetten sollen ihre Chance bekommen, bevor sie verworfen werden. Amodei verweist auf GPT-2 mit seinen bemerkenswert realistischen, automatisch generierten Texten als Beispiel dafür, warum es wichtig ist, einen offenen Geist zu bewahren. „Reine Sprache ist eine Richtung, der die Branche und sogar einige von uns etwas skeptisch gegenüberstanden“, sagt er. „Aber jetzt ist es so: ,Wow, das ist wirklich vielversprechend.‘“

Der zweite Teil der Strategie, erklärt Amodei, konzentriert sich auf die Frage, wie man solche immer weiter fortschreitenden KI-Systeme sicher machen kann. Dazu gehört, dass sie menschliche Werte widerspiegeln, die Logik hinter ihren Entscheidungen erklären und dabei lernen können, ohne Menschen zu schaden. Teams, die sich mit jedem dieser Sicherheitsziele befassen, versuchen Methoden zu entwickeln, die sich projektübergreifend anwenden lassen. Die vom Erklärungsteam entwickelten Techniken können zum Beispiel helfen, die Logik hinter den Satzkonstruktionen von GPT-2 oder den Bewegungen eines Roboters aufzudecken.

Doch die massiven Ressourcen, die für solche Forschungsarbeiten notwendig sind, kosten eine Menge Geld.

OpenAI muss Geld verdienen

In den Wochen nach der Umstellung auf ein Modell mit Gewinnobergrenze und der Milliardenspritze von Microsoft versicherte die Führung den Mitarbeitern, dass diese Updates den Forschungsansatz von OpenAI funktional nicht verändern würden. Eine Zeit lang schienen diese Zusicherungen zu stimmen, und die Projekte wurden unverändert weitergeführt. Viele Mitarbeiter wussten nicht einmal, welche Zusicherungen, wenn überhaupt, Microsoft bekommen hatte.

Aber in den letzten Monaten hat sich der Druck der Kommerzialisierung verstärkt. OpenAI muss Geld verdienen, um Forschung zu betreiben – nicht umgekehrt.

Dies ist ein harter, aber notwendiger Kompromiss, sagte die Führung – ein Kompromiss, den sie aus Mangel an wohlhabenden philanthropischen Spendern eingehen musste. Aber die Wahrheit ist, dass OpenAI vor diesem Kompromiss steht, weil es die strategische Entscheidung getroffen hat, zu versuchen, AGI vor allen anderen zu erreichen. Dieser Druck zwingt OpenAI dazu, Entscheidungen zu treffen, mit der sich die Organisation immer weiter von ihrer ursprünglichen Absicht entfernt. Das Unternehmen befördert den Hype um KI, um Geld und Talente anzuziehen. Es hält seine Forschungsergebnisse zurück, in der Hoffnung, die Oberhand zu behalten, und es setzt auf brutale Rechenkraft – nicht, weil dieser Weg als der einzige zu AGI angesehen wird, sondern als der schnellste.

(jle [7])

URL dieses Artikels:

https://www.heise.de/-4697816

Links in diesem Artikel:

[1] https://www.heise.de/select/tr/2020/4/

[2] https://www.heise.de/thema/Kuenstliche-Intelligenz

[3] https://www.heise.de/news/Gruende-fuer-Altmans-Entlassung-Angeblich-Durchbruch-bei-AGI-9537095.html

[4] https://www.heise.de/hintergrund/Googles-Intelligenz-Designer-3132471.html

[5] https://www.heise.de/hintergrund/Kuenstliche-Intelligenz-Fortsetzung-folgt-4403643.html

[6] https://www.heise.de/hintergrund/Fake-News-zu-50-Prozent-perfekt-4512589.html

[7] mailto:jle@heise.de

Copyright © 2020 Heise Medien